在2025年人工智能电路与系统(AICAS)会议Grand Challenge赛事中,来自集成电路学院的两支队伍凭借创新的技术方案,从全球数十只支报名参赛队伍中脱颖而出,分别摘得第二赛道(大模型硬件系统设计)的冠军和亚军,其成果为解决边缘计算场景中大模型高效部署提供了新的思路。其中,获得冠军的队伍由集成电路学院王源教授与李萌研究员联合指导,参赛学生包括郭晴宇、钟林峰、许颂强和魏仁杰;获得亚军的队伍为北京大学-安徽工程大学联队,由集成电路学院孙广宇副教授指导,参赛学生包括薛晨皓、周进伟、任毅、董锡平、张佳兴。

图1:获奖证书

背景链接1-国际会议

IEEE人工智能电路与系统国际会议(AICAS)是人工智能与集成电路交叉领域的全球顶级学术会议,由IEEE电路与系统协会(CASS)主办。自2023年起,AICAS Grand Challenge赛事由上海交通大学、南京大学等高校联合发起,聚焦大语言模型(LLM)的软硬件协同优化、边缘智能等前沿方向,旨在推动AI技术在工业界的落地应用。2025年赛事由平头哥半导体、Arm、AMD等企业提供算力支持,设立三大赛道,覆盖大模型系统优化、硬件设计及AI驱动EDA等热点领域。

背景链接2-赛题背景

近年来,基于预训练与Transformer技术的大语言模型(Large Language Models, LLM)在自然语言处理的下游任务上都取得了瞩目的表现例如文本理解、文本生成、情感分析、机器翻译和互动问答等。然而,由于数据隐私、计算能效等考量,在边缘侧进行高效的LLM推理是未来的发展趋势。由于数十亿乃至上千亿的模型参数,大模型在端侧应用进行高效部署面临很大的挑战。并且模型参数量增长的速度远大于硬件性能提升的速度,学术界和工业界开始通过模型压缩、数据流优化和算子调用等软硬件协同的方法尝试在有限的硬件条件下部署和运行大模型。其中,通过设计并实现专用的加速器实现高效的LLM推理是一种切实可行的技术路线。

图2:第二赛道赛题

赛题解析与技术亮点

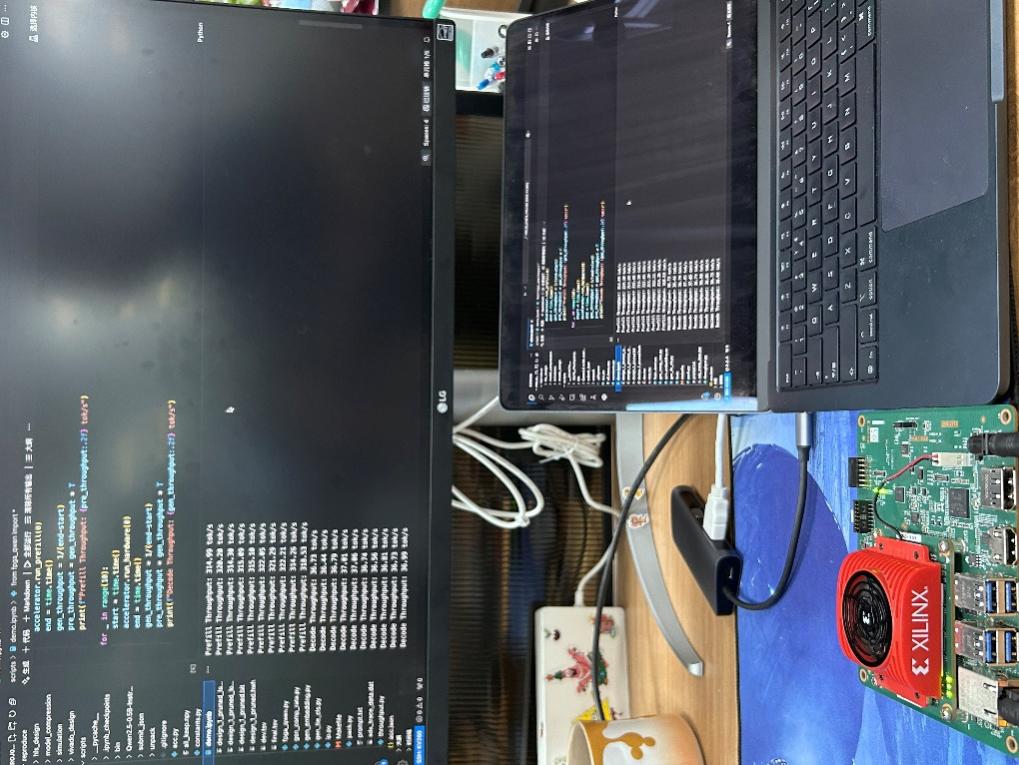

本届大模型硬件设计赛道要求参赛团队基于FPGA平台设计端侧大模型推理系统,需在资源受限条件下实现低延迟、高能效的硬件加速方案。集成电路学院团队提出“全算子融合架构”,通过优化模型计算图、设计算子调度策略,提升带宽利用率至理论值,在KV260平台上将大模型推理吞吐量提升至业界领先水平,部署大模型为Qwen2.5-0.5B-Instruct,prefill速度达到350 token/s,decode速度达到35 token/s。该方案在边缘端计算场景下表现出优异的能效与资源效率。

图3:系统测试环境和输出示例

赛事影响力与未来展望

AICAS Grand Challenge作为连接学术界与产业界的重要桥梁,其赛题设计紧密贴合行业需求。本届赛事吸引了包括北京大学、国防科技大学、复旦大学等高校和工业界的顶尖团队参与。集成电路学院将进一步探索先进人工智能模型的计算和硬件优化,助力大模型的实际应用。